IT之家 4月22日付けのニュースによりますと、外部メディアの9To5Googleが報じたところによれば、一部のGoogleメッセージアプリのユーザーに「敏感コンテンツ警告」機能の通知が届いたとのことです。この機能を有効にすると、AIを使用して敏感な画像を識別し、ぼかし処理を行うことができます。

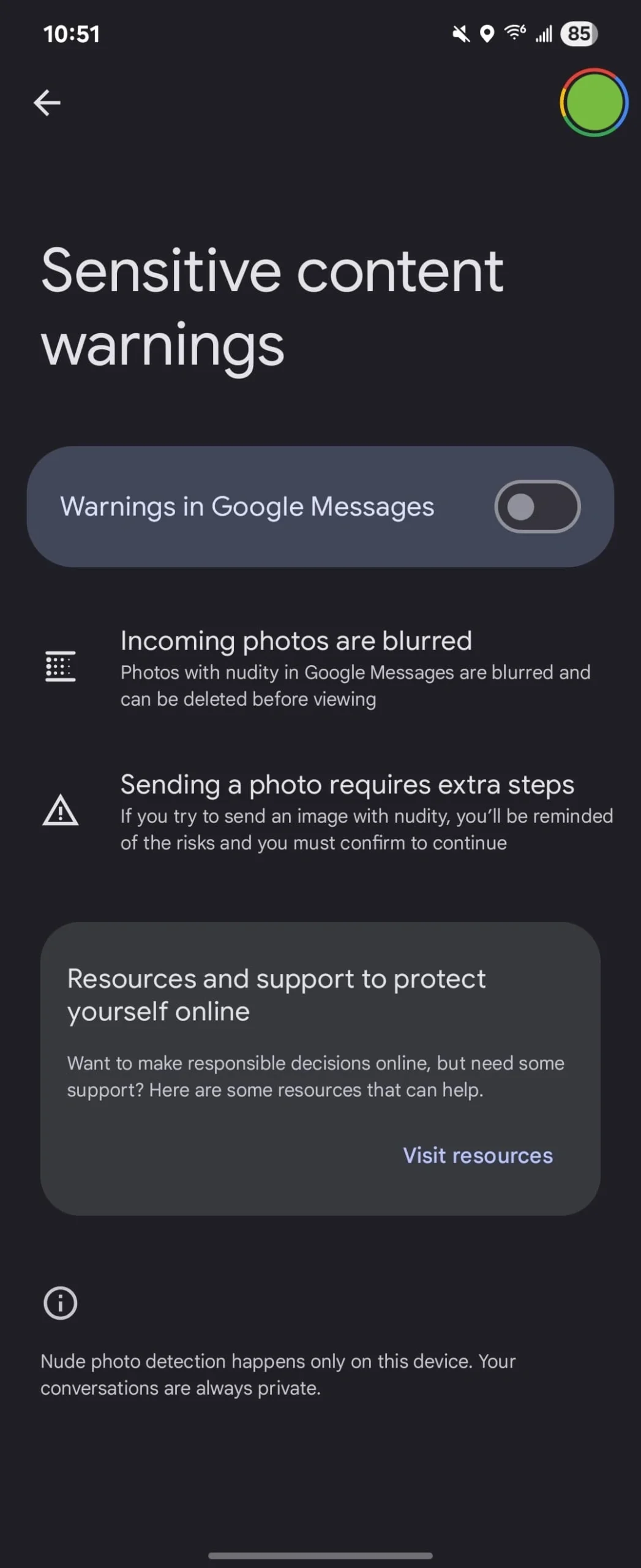

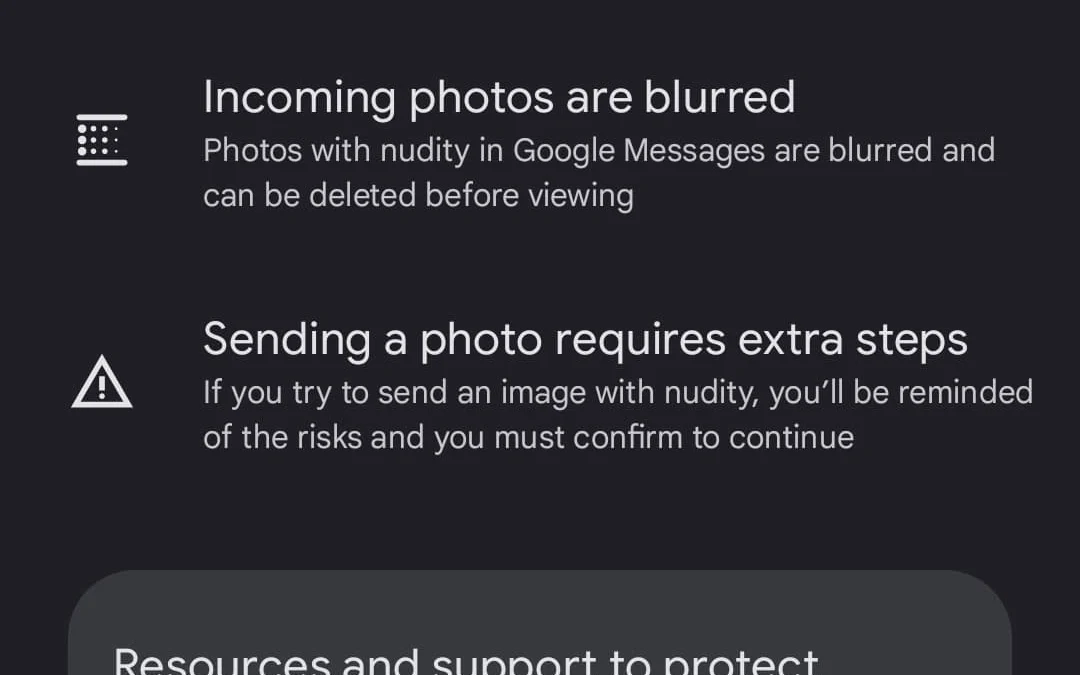

この機能が有効になると、メッセージの送信や受信時に適用されます。ユーザーが画像メッセージを受け取ると、アプリが自動的に画像を検出し、敏感なコンテンツが含まれている場合には、その画像に自動的にモザイク処理を施します。ユーザーは「原画像を表示」または「削除」を二度確認する必要があります。また、送信者を一括でブロックすることも可能です。ユーザーが画像メッセージを送信または転送する際に、画像に敏感なコンテンツが含まれているとリスク警告が表示され、手動で確認した後に送信を続けることができます。

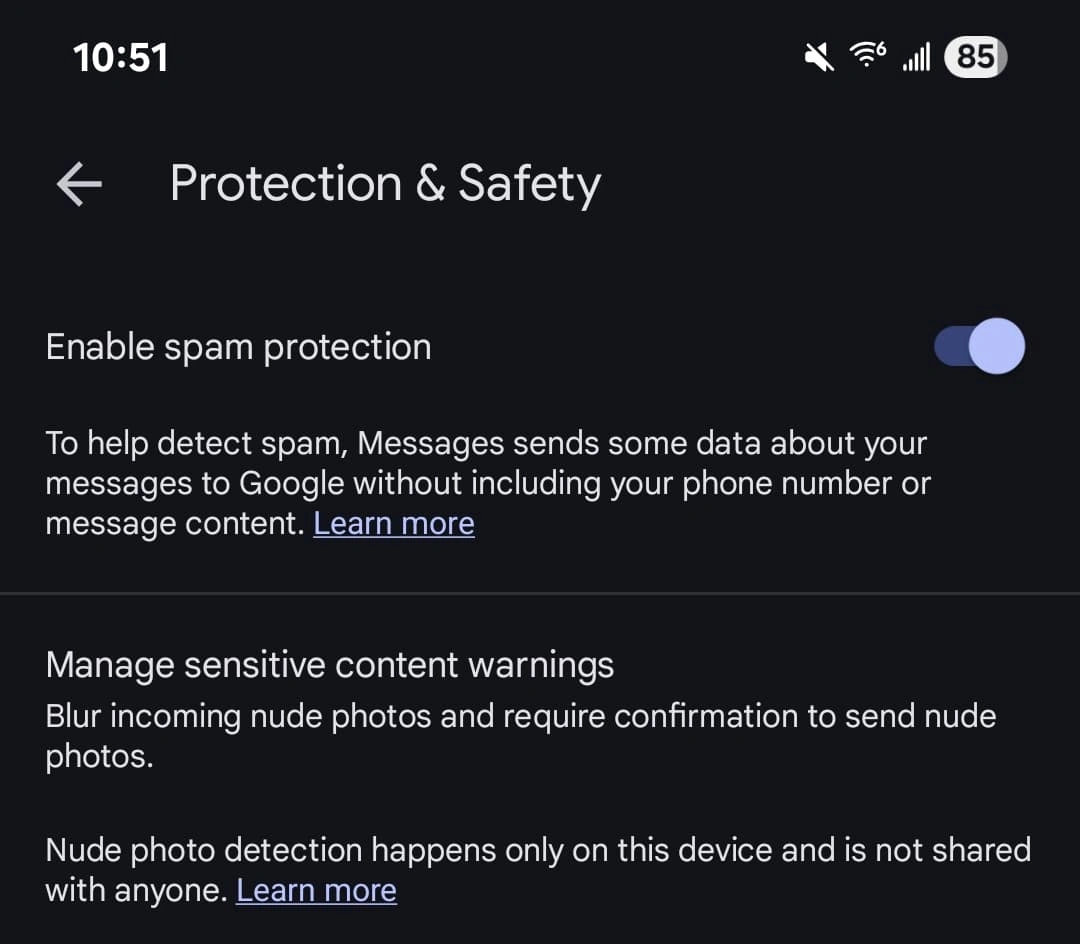

Googleによると、この機能はAndroid System SafetyCoreのローカルAI識別を使用しており、画像データをGoogleのサーバーにアップロードすることはありません。

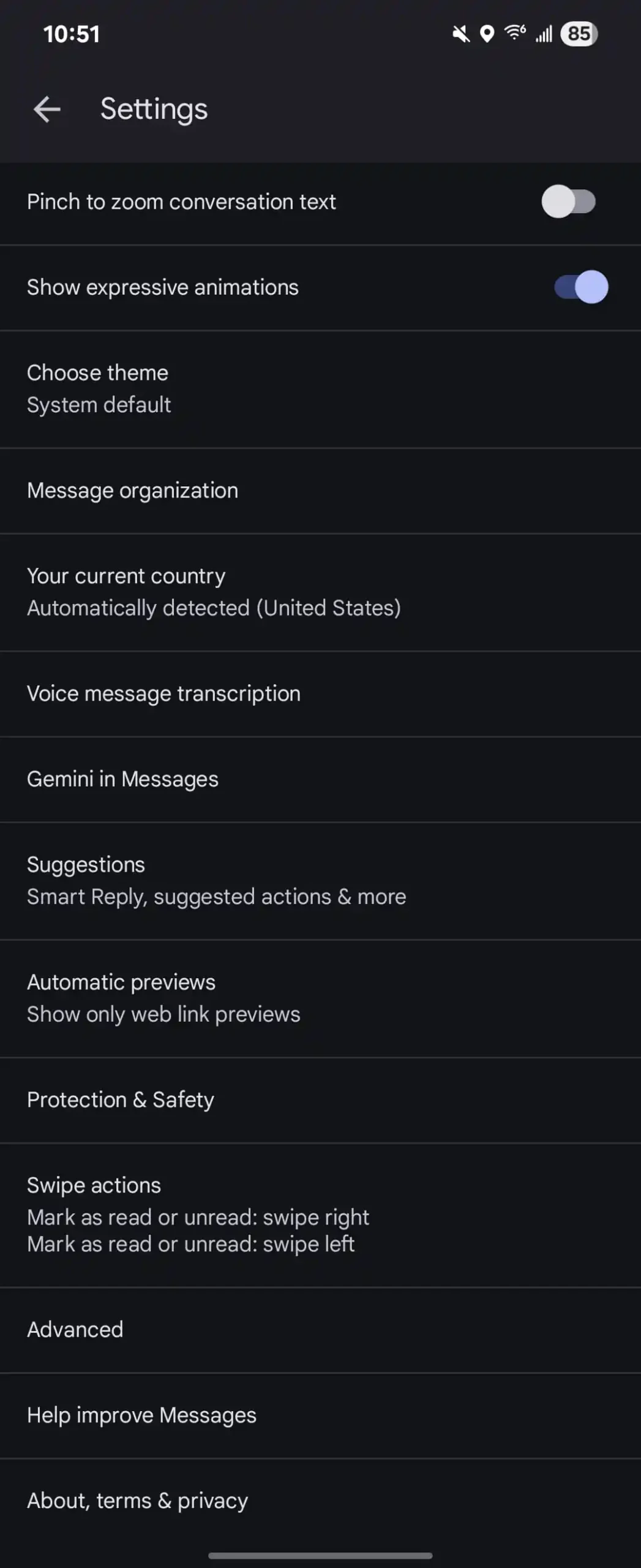

未成年者のアカウントがGoogleメッセージアプリを使用する際には、この機能はデフォルトで有効になっています。親が監視するアカウントの場合、親側のFamily Linkアプリがこの機能を制御します。親が監視しないアカウントは手動でオフにすることが可能です。成人のアカウントでは、この機能はデフォルトでオフになっており、手動で有効にする必要があります。

この機能は現在テスト段階にあり、正式な配信時期は発表されていません。9To5Googleによれば、複数のデバイスでGoogleメッセージアプリを更新しましたが、その中でこの機能が通知されたのは2台のデバイスのみでした。

IT之家の以前の報道によれば、Appleは2023年にiOS17システムに「敏感コンテンツ警告」機能を追加しました。この機能はメッセージ、AirDrop、電話アプリの連絡先ポスター、FaceTime通話、そしてサポートされているサードパーティアプリに適用され、敏感な内容を含む画像はぼかし処理が施されます。ユーザーは「表示」ボタンをクリックして原画像を確認するか、「報告」ボタンをクリックして送信者をブロックすることができます。また、検出はすべてデバイス上で行われ、Appleはユーザー間で送信される画像を全く見ることができません。

コメントを残す